![图片[1]-阿里云白嫖函数计算 FC 使用Stable diffusion+controlnet生成艺术二维码](https://www.mezhiyu.com/wp-content/uploads/2023/09/39ca9b43a9180427.png)

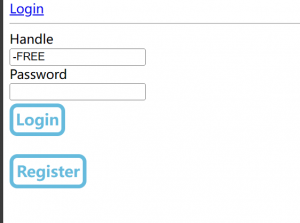

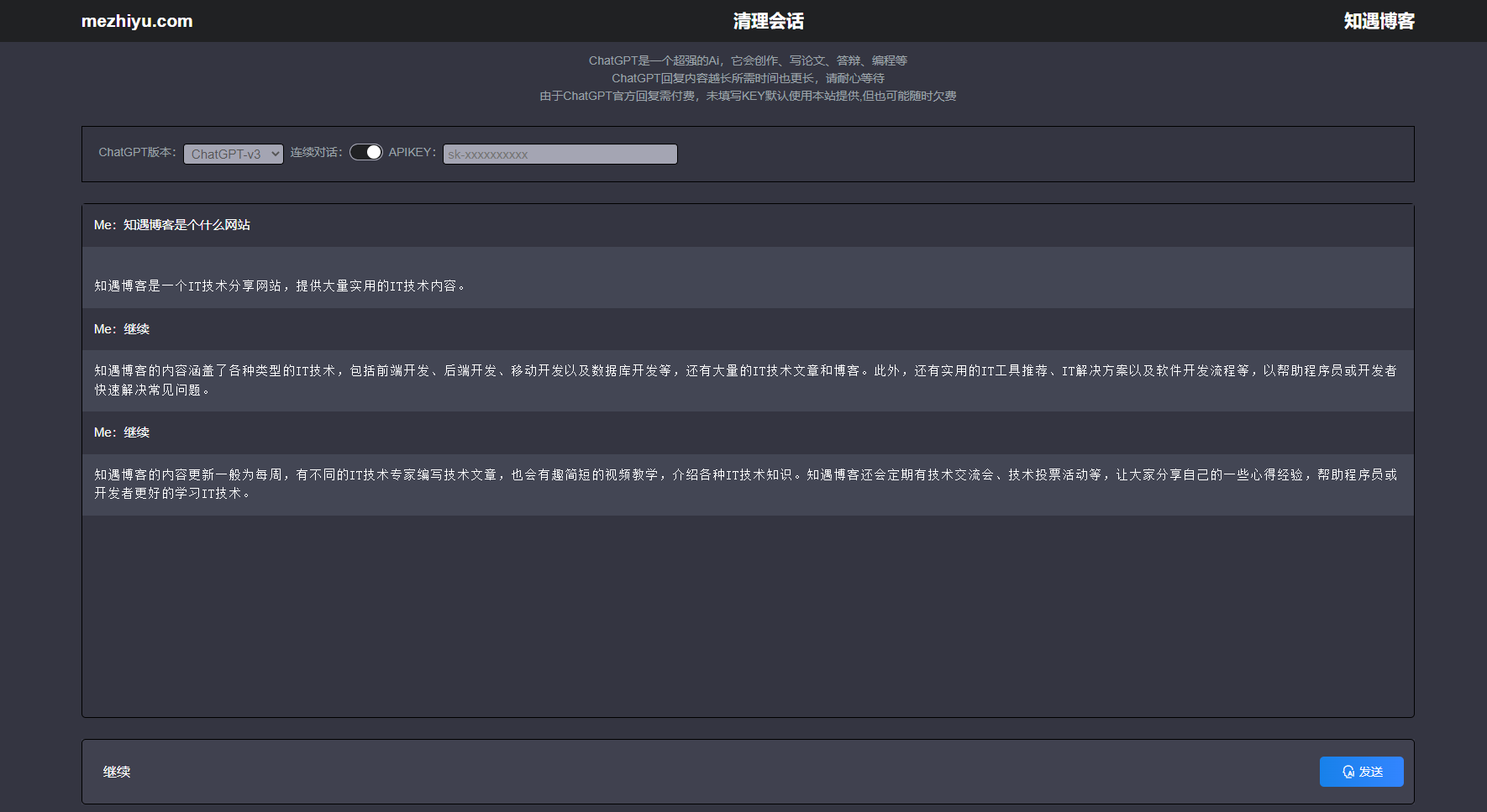

ControlNet是斯坦福大学研究人员开发的Stable Diffusion的扩展,使创作者能够轻松地控制AI图像和视频中的对象。 它将根据边缘检测、草图处理或人体姿势等各种条件来控制图像生成。 ControlNet可以概括为一种简单的稳定扩散微调方法。

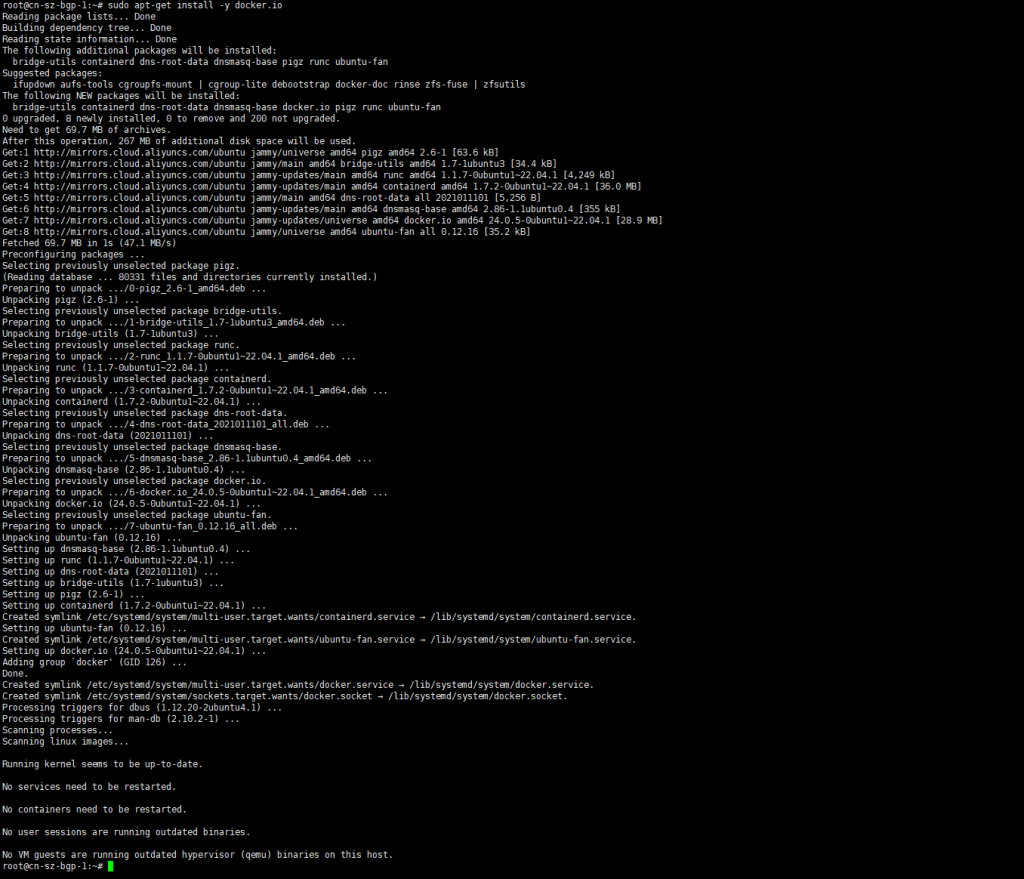

阿里云可以提供免费云计算额度试用,通过试用我们可以免费使用stable diffusion

领取地址:https://click.aliyun.com/m/1000380238/

![图片[2]-阿里云白嫖函数计算 FC 使用Stable diffusion+controlnet生成艺术二维码](https://www.mezhiyu.com/wp-content/uploads/2023/09/ea876eeea8180553.png)

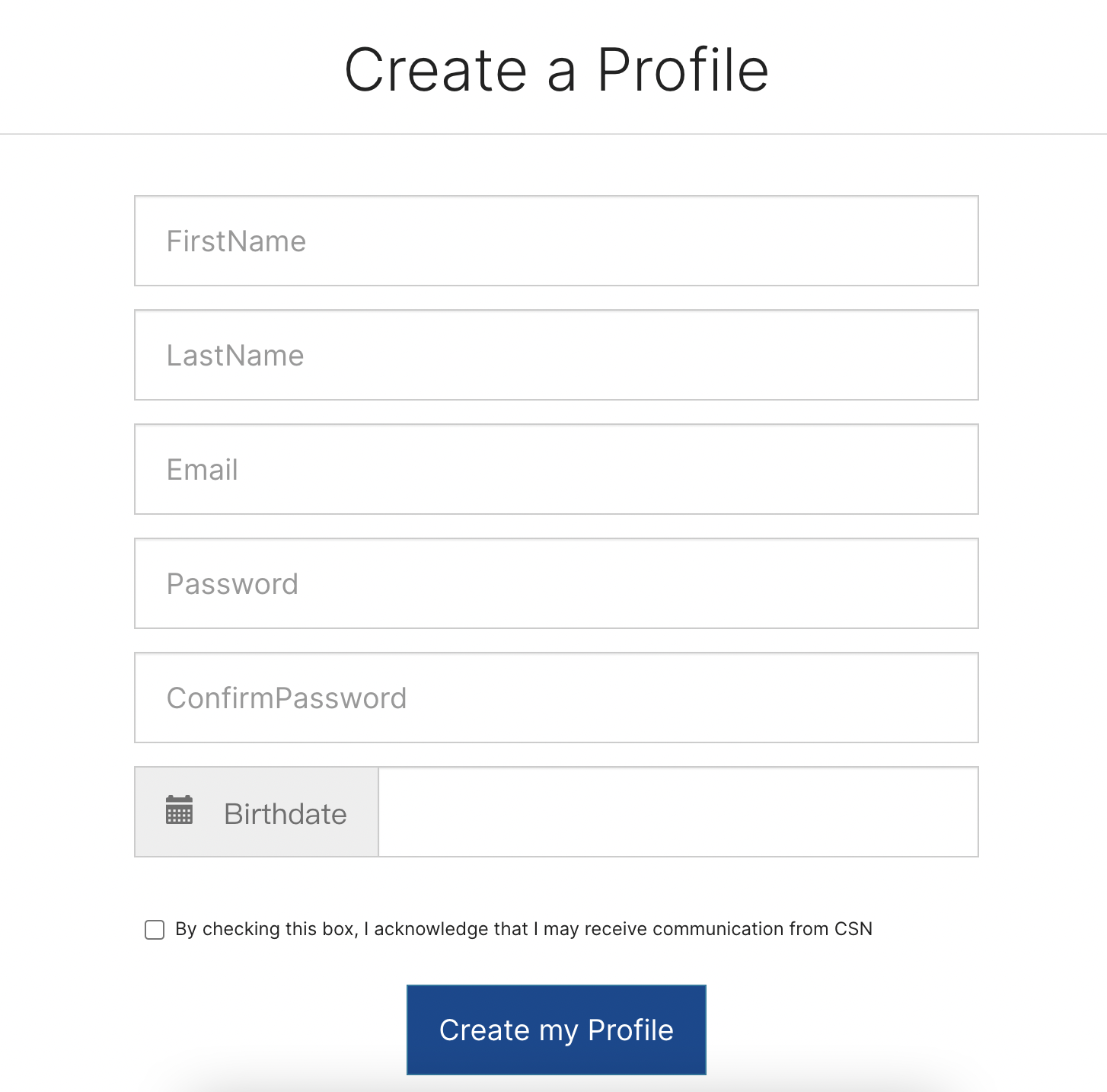

打开之后我们可以看到可以领取180元的函数计算FC额度,点击免费试用

![图片[3]-阿里云白嫖函数计算 FC 使用Stable diffusion+controlnet生成艺术二维码](https://www.mezhiyu.com/wp-content/uploads/2023/09/ea876eeea8180631.png)

然后领取免费的NAS资源

https://free.aliyun.com/?product=9657388&crowd=personal

![图片[4]-阿里云白嫖函数计算 FC 使用Stable diffusion+controlnet生成艺术二维码](https://www.mezhiyu.com/wp-content/uploads/2023/09/ea876eeea8180741.png)

点击立即试用

领取之后去函数计算FC创建应用 点击链接一键直达

![图片[5]-阿里云白嫖函数计算 FC 使用Stable diffusion+controlnet生成艺术二维码](https://www.mezhiyu.com/wp-content/uploads/2023/09/ea876eeea8180945.png)

会提示 没有AliyunFcDefaultRole角色 点击创建

![图片[6]-阿里云白嫖函数计算 FC 使用Stable diffusion+controlnet生成艺术二维码](https://www.mezhiyu.com/wp-content/uploads/2023/09/ea876eeea8181023.png)

直接点击同意授权

然后找到 AI数字绘画stable-diffusion自定义模型版 点击立即创建

![图片[7]-阿里云白嫖函数计算 FC 使用Stable diffusion+controlnet生成艺术二维码](https://www.mezhiyu.com/wp-content/uploads/2023/09/ea876eeea8181113.png)

地域选择距离你较近的就行了,建议国外,因为到时候下载模型国内可能出错,其他参数可以根据需求自行调整

![图片[8]-阿里云白嫖函数计算 FC 使用Stable diffusion+controlnet生成艺术二维码](https://www.mezhiyu.com/wp-content/uploads/2023/09/d8808b3e88181151.png)

然后点击前往授权,授权角色

然后点击创建应用即可

![图片[9]-阿里云白嫖函数计算 FC 使用Stable diffusion+controlnet生成艺术二维码](https://www.mezhiyu.com/wp-content/uploads/2023/09/41319b1679181224.png)

![图片[10]-阿里云白嫖函数计算 FC 使用Stable diffusion+controlnet生成艺术二维码](https://www.mezhiyu.com/wp-content/uploads/2023/09/41ef2a0637181315.png)

同意并继续部署

等待项目部署

![图片[11]-阿里云白嫖函数计算 FC 使用Stable diffusion+controlnet生成艺术二维码](https://www.mezhiyu.com/wp-content/uploads/2023/09/41ef2a0637181345.png)

部署完成后点击初始化模型管理

![图片[12]-阿里云白嫖函数计算 FC 使用Stable diffusion+controlnet生成艺术二维码](https://www.mezhiyu.com/wp-content/uploads/2023/09/5bae07aa8c190143.png)

NAS可能会提示未开通,因为我们刚刚已经领取过试用了直接点击立即开通即可

![图片[13]-阿里云白嫖函数计算 FC 使用Stable diffusion+controlnet生成艺术二维码](https://www.mezhiyu.com/wp-content/uploads/2023/09/5bae07aa8c190219.png)

![图片[14]-阿里云白嫖函数计算 FC 使用Stable diffusion+controlnet生成艺术二维码](https://www.mezhiyu.com/wp-content/uploads/2023/09/b7d139526e190255.png)

点击确认

![图片[15]-阿里云白嫖函数计算 FC 使用Stable diffusion+controlnet生成艺术二维码](https://www.mezhiyu.com/wp-content/uploads/2023/09/67fb050024191043.png)

创建一个密钥

![图片[16]-阿里云白嫖函数计算 FC 使用Stable diffusion+controlnet生成艺术二维码](https://www.mezhiyu.com/wp-content/uploads/2023/09/b42fd03cd8191108.png)

等待初始化完成

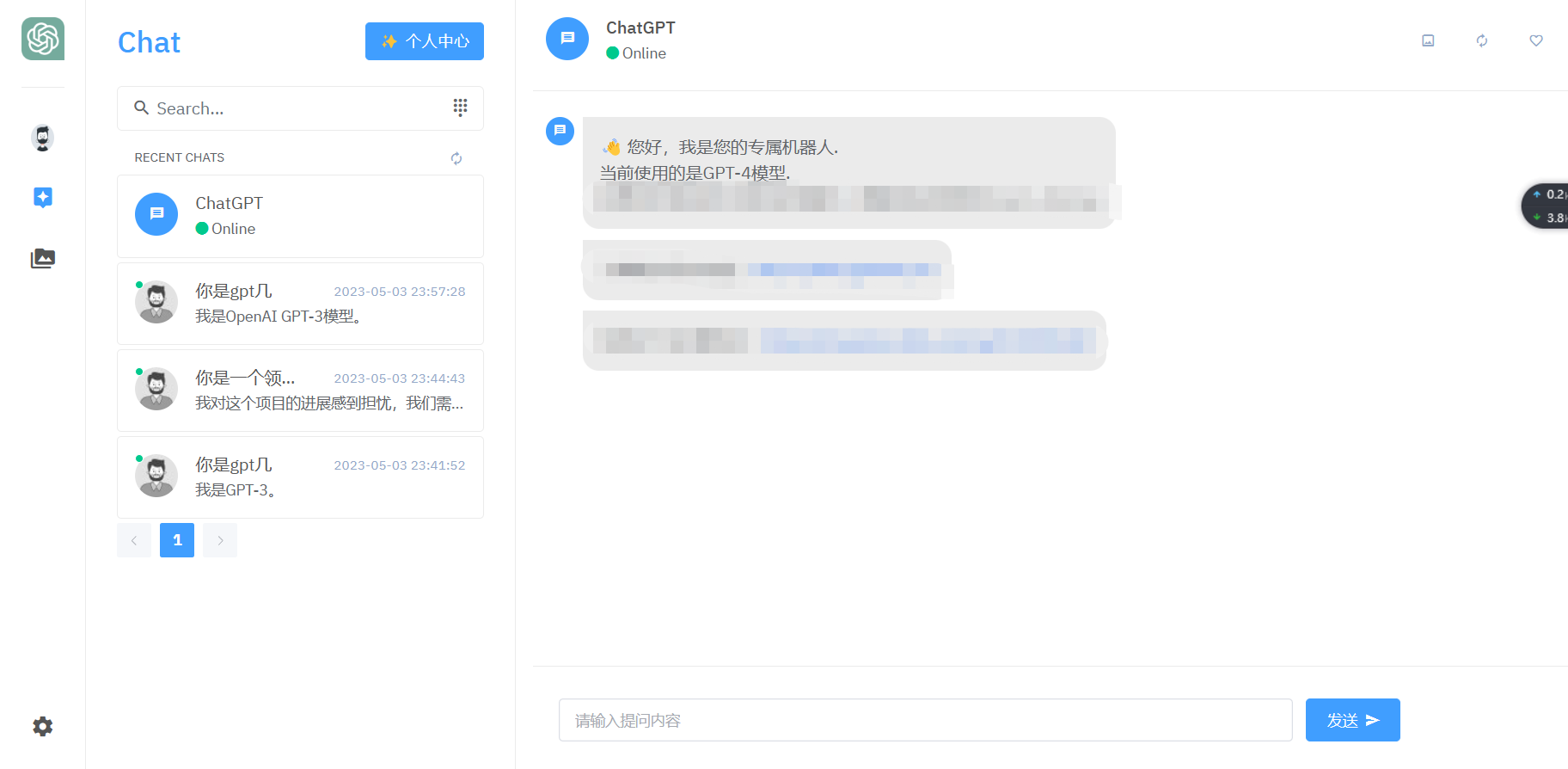

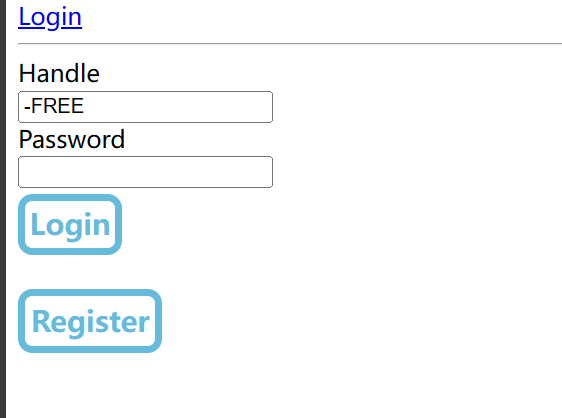

然后点击 模型管理域名 来到管理页面

![图片[17]-阿里云白嫖函数计算 FC 使用Stable diffusion+controlnet生成艺术二维码](https://www.mezhiyu.com/wp-content/uploads/2023/09/b42fd03cd8191137.png)

输入刚刚创建的密钥

![图片[18]-阿里云白嫖函数计算 FC 使用Stable diffusion+controlnet生成艺术二维码](https://www.mezhiyu.com/wp-content/uploads/2023/09/b42fd03cd8191204.png)

点击stable diffusion

![图片[19]-阿里云白嫖函数计算 FC 使用Stable diffusion+controlnet生成艺术二维码](https://www.mezhiyu.com/wp-content/uploads/2023/09/b42fd03cd8191237.png)

等待加载完成后就可以正常看到 Web UI了

![图片[20]-阿里云白嫖函数计算 FC 使用Stable diffusion+controlnet生成艺术二维码](https://www.mezhiyu.com/wp-content/uploads/2023/09/b42fd03cd8191307.png)

然后打开文件管理

![图片[21]-阿里云白嫖函数计算 FC 使用Stable diffusion+controlnet生成艺术二维码](https://www.mezhiyu.com/wp-content/uploads/2023/09/b42fd03cd8191337.png)

然后打开/mnt/auto/sd/models/ControlNet这个目录

![图片[22]-阿里云白嫖函数计算 FC 使用Stable diffusion+controlnet生成艺术二维码](https://www.mezhiyu.com/wp-content/uploads/2023/09/b42fd03cd8191414.png)

之后就是下载模型了

然后我们就需要来到huggingface

打开ioclab/ioc-controlnet at main (huggingface.co)

右键分别复制这两个模型的下载链接

![图片[23]-阿里云白嫖函数计算 FC 使用Stable diffusion+controlnet生成艺术二维码](https://www.mezhiyu.com/wp-content/uploads/2023/09/b1464c823b214055.png)

在文件管理中 上传>离线上传 粘贴下载链接

注意:如果无法正常下载可以选择将huggingface的模型下载到本地手动上传

![图片[24]-阿里云白嫖函数计算 FC 使用Stable diffusion+controlnet生成艺术二维码](https://www.mezhiyu.com/wp-content/uploads/2023/09/b1464c823b214157.png)

qrcode monster:https://huggingface.co/monster-labs/control_v1p_sd15_qrcode_monster/tree/main 同理

![图片[25]-阿里云白嫖函数计算 FC 使用Stable diffusion+controlnet生成艺术二维码](https://www.mezhiyu.com/wp-content/uploads/2023/09/b1464c823b214237.png)

全部下载完就这样子了

![图片[26]-阿里云白嫖函数计算 FC 使用Stable diffusion+controlnet生成艺术二维码](https://www.mezhiyu.com/wp-content/uploads/2023/09/b1464c823b214307.png)

接着就要准备二维码了,这里给出几个二维码生成工具

生成二维码后保存到本地

![图片[27]-阿里云白嫖函数计算 FC 使用Stable diffusion+controlnet生成艺术二维码](https://www.mezhiyu.com/wp-content/uploads/2023/09/bfb714bfe8214458.png)

回到Web UI,找到设置

![图片[28]-阿里云白嫖函数计算 FC 使用Stable diffusion+controlnet生成艺术二维码](https://www.mezhiyu.com/wp-content/uploads/2023/09/b1464c823b214526.png)

找到ControlNet

![图片[29]-阿里云白嫖函数计算 FC 使用Stable diffusion+controlnet生成艺术二维码](https://www.mezhiyu.com/wp-content/uploads/2023/09/b1464c823b214609.png)

找到Multi ControlNet: Max models amount (requires restart) 调整为4让我们可以叠加使用ControlNet

![图片[30]-阿里云白嫖函数计算 FC 使用Stable diffusion+controlnet生成艺术二维码](https://www.mezhiyu.com/wp-content/uploads/2023/09/b1464c823b214634.png)

然后点击应用设置,点击重新加载 Web UI

![图片[31]-阿里云白嫖函数计算 FC 使用Stable diffusion+controlnet生成艺术二维码](https://www.mezhiyu.com/wp-content/uploads/2023/09/b1464c823b214707.png)

重启完成后采样器选择DPM++ 2M

![图片[32]-阿里云白嫖函数计算 FC 使用Stable diffusion+controlnet生成艺术二维码](https://www.mezhiyu.com/wp-content/uploads/2023/09/b1464c823b214739.png)

高度和宽度我这里都调整成了768,可根据喜好自行调节

![图片[33]-阿里云白嫖函数计算 FC 使用Stable diffusion+controlnet生成艺术二维码](https://www.mezhiyu.com/wp-content/uploads/2023/09/b1464c823b214827.png)

ControlNet设置

unit 0

Control Weight设置 1.2-1.4区间比较合适,可根据识别率调节

Starting Control Step进场时机和Ending Control Step出场时机可根据出图效果微调

![图片[34]-阿里云白嫖函数计算 FC 使用Stable diffusion+controlnet生成艺术二维码](https://www.mezhiyu.com/wp-content/uploads/2023/11/6238af1d35004332.png)

unit 1

![图片[35]-阿里云白嫖函数计算 FC 使用Stable diffusion+controlnet生成艺术二维码](https://www.mezhiyu.com/wp-content/uploads/2023/11/6238af1d35004414.png)

unit 2

![图片[36]-阿里云白嫖函数计算 FC 使用Stable diffusion+controlnet生成艺术二维码](https://www.mezhiyu.com/wp-content/uploads/2023/11/95fa52f916004523.png)

效果图

![图片[37]-阿里云白嫖函数计算 FC 使用Stable diffusion+controlnet生成艺术二维码](https://www.mezhiyu.com/wp-content/uploads/2023/11/22826888b1010513.png)

![图片[38]-阿里云白嫖函数计算 FC 使用Stable diffusion+controlnet生成艺术二维码](https://www.mezhiyu.com/wp-content/uploads/2023/11/f67f54389e010453.png)

![图片[39]-阿里云白嫖函数计算 FC 使用Stable diffusion+controlnet生成艺术二维码](https://www.mezhiyu.com/wp-content/uploads/2023/11/ee70c8b4c7011257.png)

采样步数可以设置多一点设置为50左右

主要还是识别率比较低,需要多尝试,修改提示词

![图片[40]-阿里云白嫖函数计算 FC 使用Stable diffusion+controlnet生成艺术二维码](https://www.mezhiyu.com/wp-content/uploads/2023/11/847359121a005150.png)

注意:阿里云函数计算FC不免费出网流量,请注意控制流量使用,以免欠费

有什么问题可以评论区留言!

![表情[yiwen]-知遇博客](https://www.mezhiyu.com/wp-content/themes/zibll/img/smilies/yiwen.gif)

暂无评论内容